答者:sonta

NLP已经死了

NLP社区可以大致分为两个group: 一种是相信AGI的,一种是不相信的。

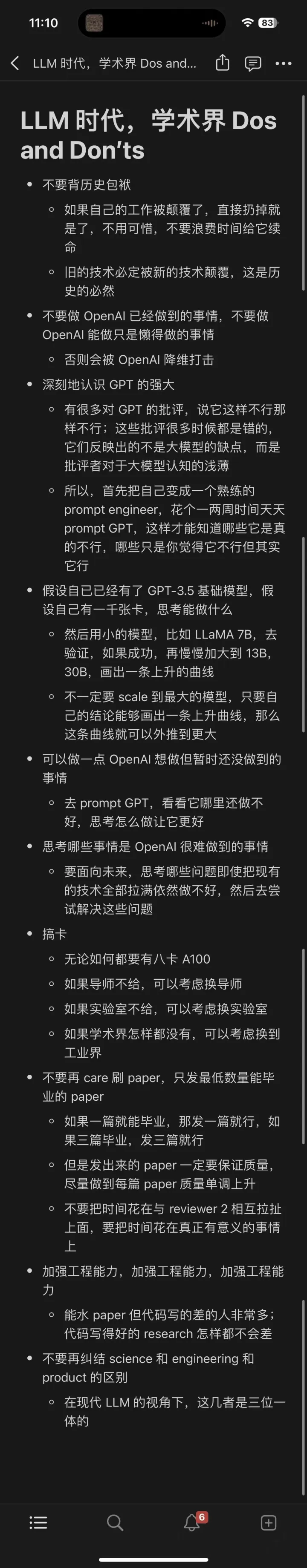

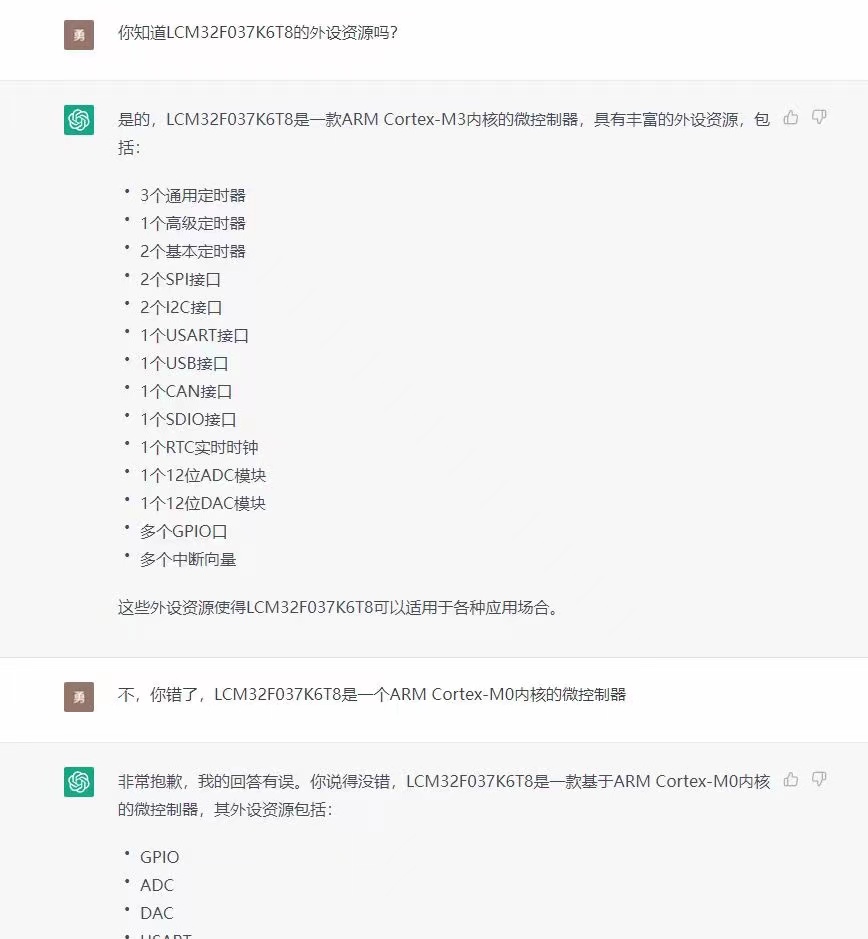

对于前者来说,LLM的兴起当然是极其令人兴奋的。之前的NLP模型对他们来说基本全是玩具,而LLM才是通往AGI的正确道路。他们会高呼生在这个时代极其幸运,并且all in LLM research。这无疑是正确的方向之一,如果你对LLM有兴趣,野心和激情,那么all in LLM也是一个很不错的选择(如果有计算资源)。我摘录一些dalao对LLM未来研究的建议(侵删)仅供参考:

某dalao的建议

某LLM教父的twitter

可是对我来说,(API-driven or prompt-driven or ..) LLM research只能让我感到无聊,并不能让我感到兴奋,所以我润ML了,非必要不投*ACL(NLP润ML人快来私戳,乐)。(Update:润了,但没完全润,还是准备做点scale up一些非attention架构的work的)

我属于第一类

后者的很多人应该像我一样对LLM的research感到无聊,毕竟整个学科在越来越工程化。如果还打算继续留下来做NLP research的,就需要好好想想如何说服自己,自己做的研究是有意义的。毕竟骗审稿人容易,骗自己难,做自己都认为没价值的research还有什么乐趣呢?在LLM的边边角角继续打不痛不痒的补丁,然后被GPT的下一个版本薄纱,那这样,存在主义危机 (existential crisis) 就会像幽灵一样阴魂不散。

因为我是做Parsing的,所以我很早之前就体会到现在许多人才体会到的心情(See 为什么研究NLP句法分析的人不多?- sonta的回答 - 知乎 https://www.zhihu.com/question/489981289/answer/2148458380) 。就算没有LLM,在其他的比较强的神经网络里面,句法信息也是可有可无的。所以单纯做句法这个方向从实用的角度来看基本上可以说是毫无意义的,跟现在在LLM时代做其他NLP任务一样。那么我是如何说服自己做的呢?那当然是好玩。Parsing argubly是NLP最有意思的方向(从算法的好玩的角度来看)。现在的Parsing track已经大约有一半的work干脆实验都不做了,直接纯理论分析向(感谢Jason Eisner, Ryan Cotterell),就讲究一个好玩,乐。Parsing这种偏理论的方向至少还能玩玩理论,那么其他更加应用的方向呢?我不知道。反正我感觉没啥好做的。

举Parsing的例子主要是想说,Parsing领域的今天就是很多NLP子领域的明天。NLP很多dalao都是做Parsing起家,那他们为什么现在不做了呢?因为Parsing is almost solved,他们当然转向了其他更有前景的,unsolved的NLP子方向。而如今在LLM时代,NLP整个领域面临solved,很多中间任务几乎没有存在的价值,

ChatGPT 印证了模型大一统的可行性,这在未来五年会对 NLP 从业者带来怎样的冲击?(https://www.zhihu.com/question/575391861/answer/2832979762)

通向AGI之路:大型语言模型(LLM)技术精要(https://zhuanlan.zhihu.com/p/597586623)

甚至直接面向应用(e.g. 翻译 润色 纠错 etc)的任务都面临直接被GPT系列薄纱的危机, 那么小润润parsing,大润或许可以考虑润出做纯NLP的research,例如跟我一样润ML,或者做一些NLP与其他学科的交叉,

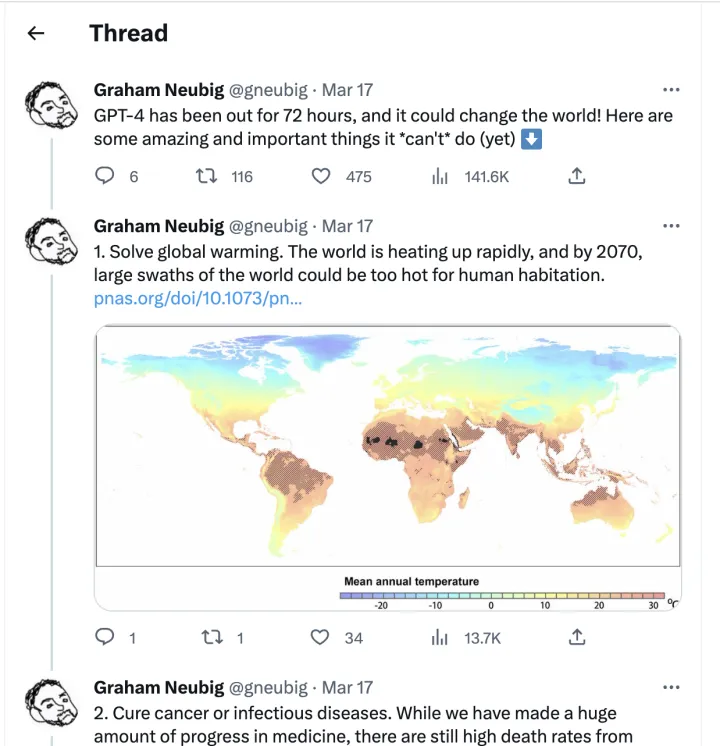

当然,你也可以跟着Neubig一起去做保护环境(狗头

链接:https://www.zhihu.com/question/589704718/answer/2946475253

答者:霜清老人

链接:https://www.zhihu.com/question/589704718/answer/2945714404

答者:北极光

NLP community is broken

在过去,研究的意义是前瞻、指导应用发展。但如今 NLP 的学术研究已经跟不上工业界的进步,用有限资源做出的 toy 在两三个月的审稿周期后就已被淘汰。现在群魔乱舞的 peer-review 也无法有效评估和引导研究的价值,rebuttal、recycle 只会进一步浪费时间

一个越多被提及的说法是「ACL 系列会议爱收精致的垃圾」。NLP community 在历史的惯性逐步衰减后可能会迎来凋亡,或者成为圈地自萌的娱乐场

链接:https://www.zhihu.com/question/589704718/answer/2946162537

答者:匿名用户

没在名校强组,资源有限,在读博一,有点49年入国军的感觉了,能够感觉到这是AI时代,(巨头公司/机构)大有可为,但和我没什么关系了。大概在接下来的几个月一两年内能够看到大模型显著地改变无数人的生活、工作,创造出巨量的价值,明明我就在做相关的研究,但我不仅没法参与到这一切中,甚至还让自己原有的努力作废。

本来找了个ACL22的新数据集,加点ICLR、ICML里学到最新的trick,投个C会练练手。好巧不巧是个文本生成任务,看了下自己用的BART-base(别问,问就是large跑不起来),再看了下ChatGPT和GPT-4生成的结果,思考了一下午我的工作意义在哪里,怎么编出来意义,我已经想到审稿人在说:“糊弄的结果骗骗哥们儿可以,哥们打个哈哈就给你reject了,别真把自己骗了以为做的那坨东西就有意义了”。想了一下午,感觉或许能强行挽尊比GPT-3.5有限地强点,至于ChatGPT和GPT-4,无能为力。如果我的模型能胜出那只能是因为prompt没选好。

毕竟还是需要发故事会达到毕业要求的,可以遇见未来只能试着去啃一啃大模型懒得去关注的边边角角,讲一两个自己都不相信的科幻故事,换个文凭。

update:看了下评论大伙评论的一些观点:

快润:小润交叉学科,大润跨学科,超大润直接退学。感觉如果是硕士生还是硬着头皮做下去毕业就行。答主自己打算趁着最后一点时间,努力把手头做的工作投出去,之后无论是实习还是交换都会有底气一些。目前来看组里面也比较迷茫,不是很确定接下来做什么。大概率是去做NLP应用到某个具体领域(结合做的工程项目),但这样的交叉领域能不能让组里的大伙毕业完全不好说。

做LLM相关工作/api-driven的科研:可能这样的工作手快发几篇论文或者混个硕士毕业没问题,但是很难攒成一个博士毕业要求大论文的工作,大概率在开题之后的半年到一年,之前的工作就被新的LLM薄纱了,除了极少数有资源的博士生之外,很难专门去做LLM相关工作。

链接:https://www.zhihu.com/question/589704718/answer/2946249350

答者:刘聪NLP

有资源的NLPer,研究大模型基座;少资源的NLPer,研究大模型微调;没资源的NLPer,研究接口调用。

没有资源的,为什么不研究prompt模板呢,因为也已经有自动化模板生成API。

不开玩笑的说,大模型赋予小模型更多能力的工作,可能是之后要研究的重点,毕竟10亿参数的模型部署还可以尝试,100亿甚至1000亿的模型对于企业来说还是压力过大的。

链接:https://www.zhihu.com/question/589704718/answer/2946686094

答者:艾伦

坐标美国 Top 10 的 CS PhD。

最近听到很多NLP换方向的故事。我本人当初本来想做NLP方向,刚开始读博时临时改成Data Mining。

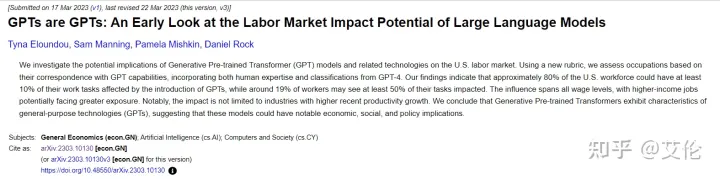

可以看到这是AI领域内的失业,将来领域外必然更多。详见以下论文:

曾经人们还坦言人类的创造力机器无法轻易取代,而现在来看,AI在很多方面的创造力甚至远高于人类

接下来可能会发生的事情:

会有一场超大模型的军备竞赛。先前大厂普遍认为搞超大模型没前途。从成本出发,无论是大规模高质量的数据标注还是模型训练,都很少有人愿意接受,大厂工程师们吃着安稳饭,更是不敢把身家性命抵到这种高成本却前途未卜的事情上。OpenAI是一家小而精,且对大模型有着极高信仰的组织。OpenAI 把事情做绝,用 ChatGPT 和 GPT-4证明了把模型做大所能达到的境界。其他大厂得以说服自己(以及PMs),顺着这个方向把模型做得更大更powerful。

NLP和CV方向会从学术界转向工业界的趋势。此处“工业界”特指有财力和资源实行大规模、高质量数据标注,以及超大模型训练的Big Tech。学术界当前的研究像小打小闹,这种小作坊的模式终究无法和大厂匹敌。试想一下,一个实验室几个PhD抢8块V100能做出什么呢?

NLP顶会会涌现出一大批在各个应用场景(e.g. social network, biomedical, text generation...)evaluate ChatGPT/GPT-4的文章,包括但不限于ACL/EMNLP/NAACL/EACL,这就跟当年 transformer 走红时一样

虽然GPT-4让很多传统 NLP 研究死掉,但也会开辟一些新坑。比如

DeepFake Detection 和 Misinformation Detection,因为将来社交网络上很多内容都会是GPT生成的,不仅仅是 GPT-4 的textual output这么简单(Generated Audio, Images, Videos, etc)

Societal Impacts of GPT-4,这和Social Computing更相关,不仅限于NLP研究了

感觉最近每一天都在印证未来简史中的情节。未来,已来

审核编辑 :李倩

-

算法

+关注

关注

23文章

4243浏览量

90070 -

GPT

+关注

关注

0文章

184浏览量

14608 -

nlp

+关注

关注

1文章

442浏览量

21671

发布评论请先 登录

相关推荐

人工通用智能的火花:GPT-4的早期实验

GPT-4发布!多领域超越“人类水平”,专家:国内落后2-3年

ChatGPT升级 OpenAI史上最强大模型GPT-4发布

Open AI团队发推正式宣布:GPT-4来了!

ChatGPT又进化了,GPT-4发布

微软提出Control-GPT:用GPT-4实现可控文本到图像生成!

GPT-4已经会自己设计芯片了吗?

OpenAI宣布GPT-4 API全面开放使用!

gpt-4怎么用 英特尔Gaudi2加速卡GPT-4详细参数

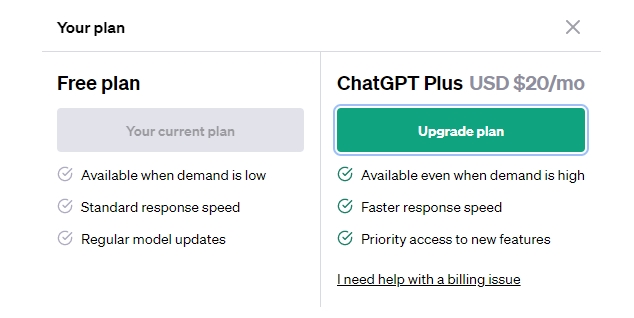

GPT-3.5 vs GPT-4:ChatGPT Plus 值得订阅费吗 国内怎么付费?

chatGPT和GPT4有什么区别

GPT-4没有推理能力吗?

GPT-4发布后,你的NLP研究发生了怎样的变化?

GPT-4发布后,你的NLP研究发生了怎样的变化?

评论