英伟达GTC:ChatGPT专用Hopper GPU H100 NVL来了

ChatGPT 一经推出火爆程度让人咋舌,似乎一夜之间就将生成式 AI、大语言模型推到了风口浪尖。英伟达估计也要笑出声来,黄仁勋预计英伟达2023年的生成式人工智能的收入将相当大,人工智能及其基础设施即服务(infrastructure as-a-service)产品将拓展其商业模式。

要之前此前NVIDIA就已经入局,在2016年,NVIDIA就向OpenAI交付了第一台NVIDIA DGX AI超级计算机——支持 ChatGPT 的大型语言模型突破背后的引擎。现在GPT-4需要的算力更大,对速度需求更强烈。

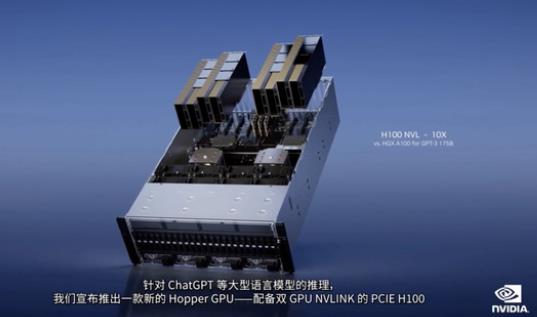

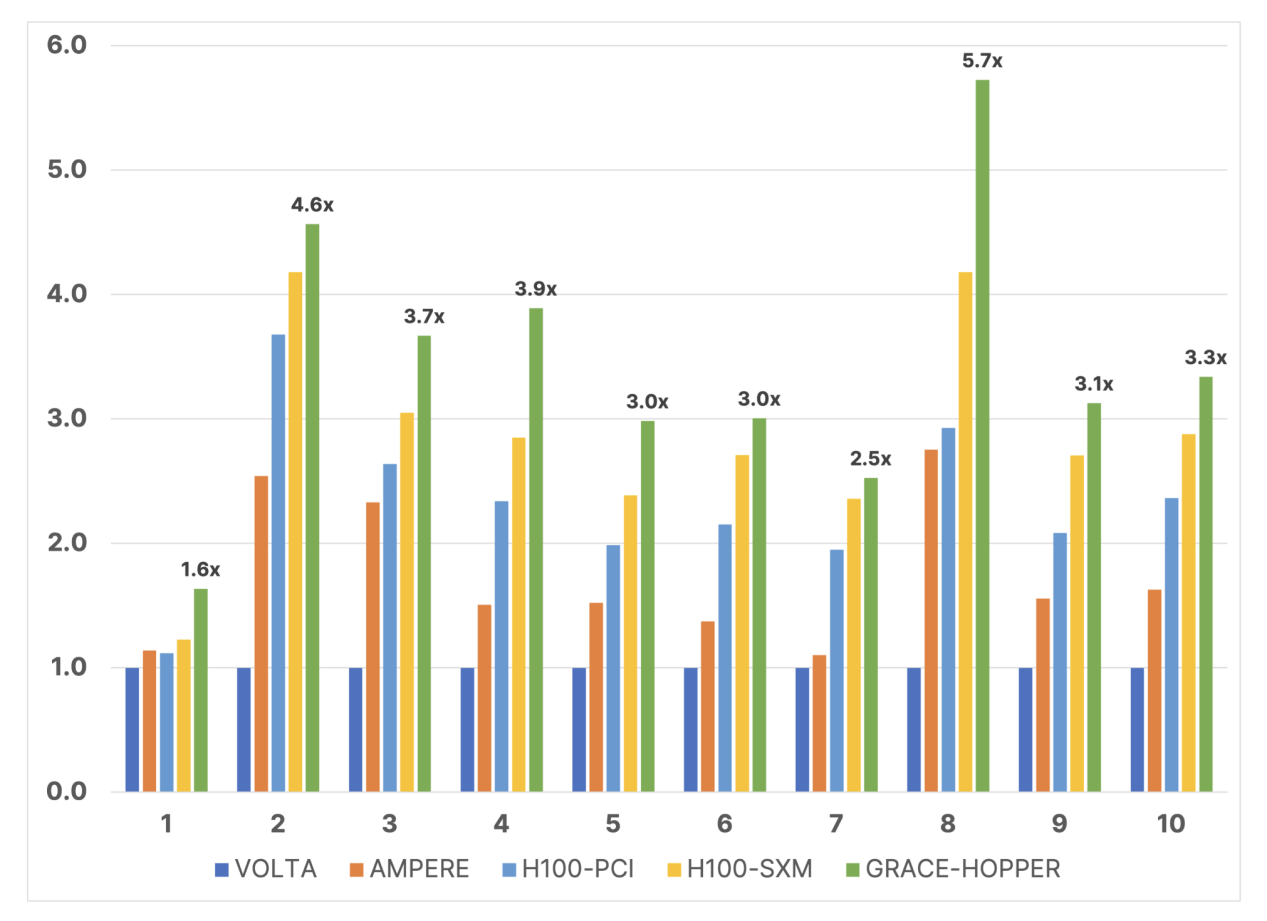

现在英伟达面向人工智能及其基础设施强发力,GPU提速,ChatGPT专用Hopper GPU H100 NVL性能强大,ChatGPT专用GPU可提速10倍,H100 NVL是专门为LLM设计的GPU,采用了Transformer加速解决方案,可用于处理ChatGPT。相比于英伟达HGX A100,一台搭载四对H100和双NVLINK的标准服务器速度能快10倍,可以将大语言模型的处理成本降低一个数量级。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

gpu

+关注

关注

27文章

3808浏览量

125067 -

AI

+关注

关注

87文章

23879浏览量

261046 -

英伟达

+关注

关注

21文章

2536浏览量

86482 -

gtc

+关注

关注

0文章

68浏览量

4228 -

ChatGPT

+关注

关注

19文章

1062浏览量

2232 -

H100

+关注

关注

0文章

26浏览量

76

发布评论请先 登录

相关推荐

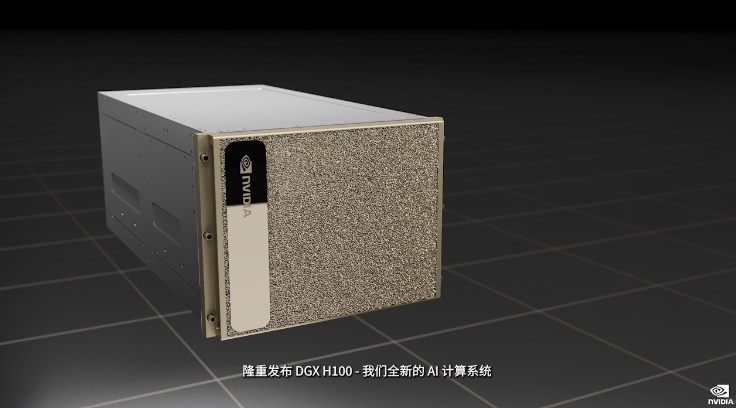

GTC2022大会亮点:NVIDIA发布全新AI计算系统—DGX H100

GTC2022大会亮点:NVIDIA发布全新AI计算系统—DGX H100,借助NVLink连接,DGX使八块H100成为了一个巨型GPU。

NVIDIA发布最新Hopper架构的H100系列GPU和Grace CPU超级芯片

英伟达)发布了基于最新Hopper架构的H100系列GPU和Grace CPU超级芯片!

GTC 2023上英伟达发布NVIDIA DGX Cloud人工智能云服务

GTC大会上线,在大会的主题演讲中,黄仁勋围绕AI、量子计算、芯片等前沿科技,发布了一系列前沿技术和产品。包括:L4 Tensor Core GPU、L40 GPU、H100

从2023 GTC谈NVIDIA硬核技术

H100 NVL。H100 NVLGPU 适用于大规模部署 ChatGPT 等大型 LLM。H100 NVL 通过 NVLINK 将两张 H100 PCIE 桥接在一起,其中的每张卡拥有 94GB HBM3 内存,同时内置 Tra

三星正与英伟达开展GPU HBM3验证及先进封装服务

英伟达将大部分gpu的高级成套产品委托给tsmc。半导体方面,将sk海力士的hbm3安装在自主制造的单一gpu芯片上,生产英伟达h100。但是最近随着生成型人工智能的普及,h100的需求剧增,在处理nvidia的所有订单上遇到了困难。

英伟达a100和h100哪个强?

英伟达a100和h100哪个强? 英伟达A100比H100更强。英伟达A100在处理大型模型和数据集时可能比V100表现更优秀。 H100 是一款针对大模型专门优化过的芯片,使用

英伟达A100和H100的区别

英伟达A100和H100的区别 英伟达A100和H100是两种不同的产品。A100是英伟达在2020年推出的一款基于Ampere架构的数据中心GPU,主要用于高性能计算和人工智能应用。A

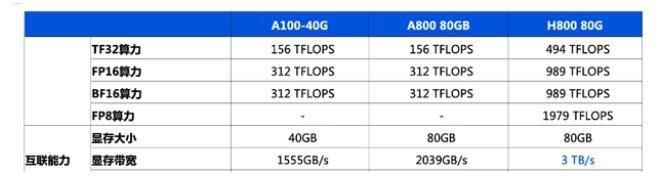

英伟达h800和h100的区别

英伟达h800和h100的区别 其实大白话就是,A100、H100是原版,特供中国市场的减配版是A800、H800。A100、H100是价格更便宜,性能更好,但是不卖,A800、H800性能

英伟达a100和h100哪个强?英伟达A100和H100的区别

GPU计算加速器,专为高性能计算、人工智能和机器学习等领域而设计。它拥有高达6912个CUDA核心(在32GB版本中),是目前最强大的数据中心GPU之一。A100支持更快的训练速度和更大的模型容量,适用于需要进行大规模并行计算的应用程序。 H100是

生成式人工智能推动,传英伟达今年将销售55万个H100 GPU

gpu的准确配置,但英伟达 h100 80gb hbm2e运算卡gpu (14592 cuda core, 26 fp64 tflops, 1513 fp16 tflops

英伟达赚翻了,分析称H100 AI GPU利润高达1000%

h100芯片的费用为3320美元。但是,目前还不清楚bom成本分析进行得有多深入。如果这是纯粹的制造成本(晶片和其他部件的平均收益率)的问题,英伟达仍需支付相当大的销售成本。

升腾910和英伟达h100对比

英伟达h100对比 随着人工智能计算进入快速发展的阶段,AI芯片的性能也越来越得到人们的关注,其中两款最受关注的芯片必须是华为的升腾910以及英伟达的H100,两者各有优劣,下面将对

MI300X能否与H100一较高下?

英伟达二季度用于AI和高性能计算应用的H100 GPU的出货量超过了900吨。并且预计其在未来几个季度的GPU销量将大致相同,因此英伟达今年将销售约3600 吨重的H100 GPU。

发表于 09-28 14:50

•122次阅读

英伟达GTC:ChatGPT专用Hopper GPU H100 NVL来了

英伟达GTC:ChatGPT专用Hopper GPU H100 NVL来了

评论