电子发烧友网报道(文/李弯弯)今年8月,在计算机图形学顶会SIGGRAPH 2023现场,英伟达发布了新一代GH200 Grace Hopper平台,该平台专为处理大语言模型、推荐系统、矢量数据库等全球最复杂的生成式 AI 工作负载而构建。

日前,这款GH200 Grace Hopper超级芯片首次亮相MLPerf行业基准测试,在此次测试中,具有更高的内存带宽和更大的内存容量的GH200与H100 GPU相比,性能高出17%。要知道,英伟达的H100 GPU产品性能在业界已经是处于遥遥领先的水平。

相比于H100 GPU,英伟达新一代GH200性能高出17%

英伟达在去年3月推出了第一代Grace Hopper超级芯片平台,首次将CPU和GPU融合在一个平台上。相比较之下,其今年8月推出的新一代产品配备了HBM3e,内存容量和带宽都有显著提高。HBM3e内存是一种新型的高带宽内存技术,可以在更小的空间内提供更高的数据传输速率。

具体来看,HBM3e比当前的HBM3快50%,可提供总计10TB/s的带宽。这使得新平台能够运行比上一版本大3.5倍的模型,同时凭借快3倍的内存带宽提升性能。

黄仁勋此前表示,为了满足对生成式AI不断激增的需求,数据中心需要能够满足特定需求的加速计算平台。全新GH200 Grace Hopper超级芯片平台以出色的内存技术和带宽,提高了吞吐量,在不影响性能的情况下可连接多GPU 以整合性能,并且具有可以轻松部署到整个数据中心的服务器设计。

此外,新平台可以通过 NVIDIA NVLink与其他超级芯片连接,使它们能够协同工作,从而部署当下大型生成式AI模型。

新平台和芯片的加持,能让大模型训练的成本得到有效降低。据黄仁勋介绍,一台服务器可以同时装载两个GH200超级芯片。而投资800万美元Grace Hopper,相当于8800个价值1亿美元的x86 GPU,意味着成本降低12倍,能耗降低20倍。

在此次MLPerf行业基准测试,英伟达这款GH200 Grace Hopper超级芯片将其性能之高展示无余。MLPerf是影响力广泛的国际AI性能基准评测,其推理性能评测涵盖使用广泛的六大AI场景,比如计算机视觉、自然语言处理、推荐系统、语音识别等,每个场景采用最主流的AI模型作为测试任务,每一任务又分为数据中心和边缘两类场景。

其由MLCommons由来自学术界、研究实验室和行业的人工智能领导者组成的联盟开发,旨在对硬件、软件和服务的训练和推理性能“构建公平和有用的基准测试”。

据介绍,此次MLPerf Inference v3.1基准测试是继4月发布3.0版本之后的又一次更新,值得注意的是,这次更新包含了两个第一次:引入基于60亿参数大语言模型GPT-J的推理基准测试和改进的推荐模型。

GPT-J是来自EleutherAI的OpenAI GPT-3的开源替代品,现已在MLPerf套件中用作衡量推理性能的基准。与一些更先进的人工智能模型(如1750亿参数的GPT-3)相比,60亿参数的GPT-J属于相当轻量的模型,但它非常适合推理基准的角色。该模型总结了文本块,并可在延迟敏感的在线模式和吞吐量密集型的离线模式下运行。

GH200 Grace Hopper超级芯片在GPT-J工作负载方面取得了优异的成绩,在离线和服务器场景中的每加速器性能都达到了最高水平。

包括特斯拉,众多企业积极构建算力芯片和集群

随着人工智能技术的发展,尤其是近年来生成式AI及大模型应用的快速拓展,市场对算力的需求快速增加。我们知道,无论是AI训练还是推理,都需要大量的算力作为支撑。而目前在大模型的训练和推理方面,英伟达的GPU占据重要位置。

今年以来,英伟达的A100和H100两款芯片订单不断增加,价格也在一直上涨。根据其最新的第二财季报告,其净利润达到61.88亿美元,与去年同期相比增长422%,较上一财季增长203%。据业内人士推测,英伟达H100芯片明年出货量还要至少增加两倍。

在AI迅猛发展的当下,除了英伟达,国内外企业都在积极研发AI芯片,构建自己的算力集群,比如英特尔、AMD此前都针对AI大模型推出了相应的大算力芯片产品。国内的不少GPGPU企业及云服务厂商也都在积极布局。

此外,作为全球知名的自动驾驶企业,特斯拉也早已开始研发自己的算力芯片,打造自己的超级计算机。最近,特斯拉的股票大涨,摩根士丹利分析师认为,特斯拉超级计算机Dojo释放人工智能提升业绩的巨大潜力,成为其股价走强的主因之一。

在产品形态上,特斯拉的Dojo最终落地单位是一个名为ExaPOD的超级计算集群。它集成了3000颗基于7nm制程工艺的D1芯片,包含120个训练模块,最终能够实现高达 1.1 EFlops(百亿亿次浮点运算)的BF16/CFP8峰值算力;1.3TB高速 SRAM;13TB高带宽 DRAM。

在2021年的特斯拉AI Day上,Dojo超算项目负责人Ganesh Venkataramana展示了集成了25个D1芯片的训练模块,他表示特斯拉找到的一个关键答案是用台积电的InFO_SoW整合扇出技术。这是一种芯片先进封装技术,相比于传统的打线封装,InFO技术的基本优势是可以实现多个芯片集成封装,加速信号传递。

特斯拉打算利用Dojo对海量视频数据进行无监督学习,加速Autopilot和完全自动驾驶(FSD)系统的迭代,同时为其人形机器人Optimus提供算力支持。

在2022年9月的AI Day上,特斯拉公布Dojo已建立完整的散热盘上系统。同时也宣布了未来路线图,表示AI团队正在研发新版本的Dojo超算组件。

据今年7月20日的报道,特斯拉Dojo超算已在今年7月开始量产,而总算力达100ExaFLOPs的超算系统将于2024年底量产。

特斯拉之前已经构建基于英伟达GPU的大型超级计算机,而如今其自主研发并推出D1芯片,有助于其减少对英伟达GPU的依赖。

小结

从目前的情况来看,英伟达在AI训练和推理中占据极大的市场份额,在大模型领域更是占据绝对优势,国内外大部分企业都依赖英伟达A100、H100等产品,而如今其GH200在性能上更强,在大模型训练方面又能够帮助企业降低成本,必然会受到一众企业追捧。

当然除了英伟达,国外内还有众多企业也在通过自己的方式,研究并发布适合AI训练和部署芯片,为AI行业的发展构建算力集群。可以看到,在生成式AI、大模型的发展下,作为基础支撑的算力尤为重要。

-

特斯拉

+关注

关注

66文章

5536浏览量

125171 -

英伟达

+关注

关注

21文章

2517浏览量

86478

发布评论请先 登录

相关推荐

rx580算力,rx580显卡算力,rx588算力,rx588显卡算力 精选资料分享

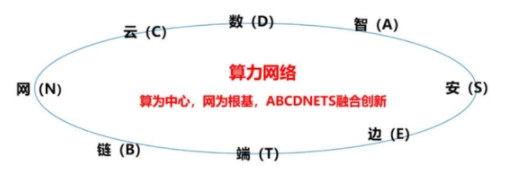

算力网络:算力和网络的关系

算力网络是什么意思

搭载256颗GH200超级芯片的超级计算机

英伟达a100显卡算力介绍

英伟达A100的算力是多少?

生成式AI新增多重亮点,英伟达推出超级芯片GH200 Grace

超级芯片GH200发布,AI算力是H100的两倍

全球GPU呈现“一超一强”竞争格局

英伟达GH200、特斯拉Dojo超级算力集群,性能爆棚!算力之争加剧!

英伟达GH200、特斯拉Dojo超级算力集群,性能爆棚!算力之争加剧!

评论